为了利用海量无标注语料库,HanLP2.0使用了许多预训练的语言模型(word2vec、fasttext、BERT、ALBERT……)。这些语言模型通常体积较大并且由海外研究机构发布,国内下载速度较慢。为此,我创建了这个共享文件夹,作为~/.hanlp(Windows的%appdata%/hanlp,下同)目录的镜像同步更新。

使用方法

- 下载此目录下的子目录到

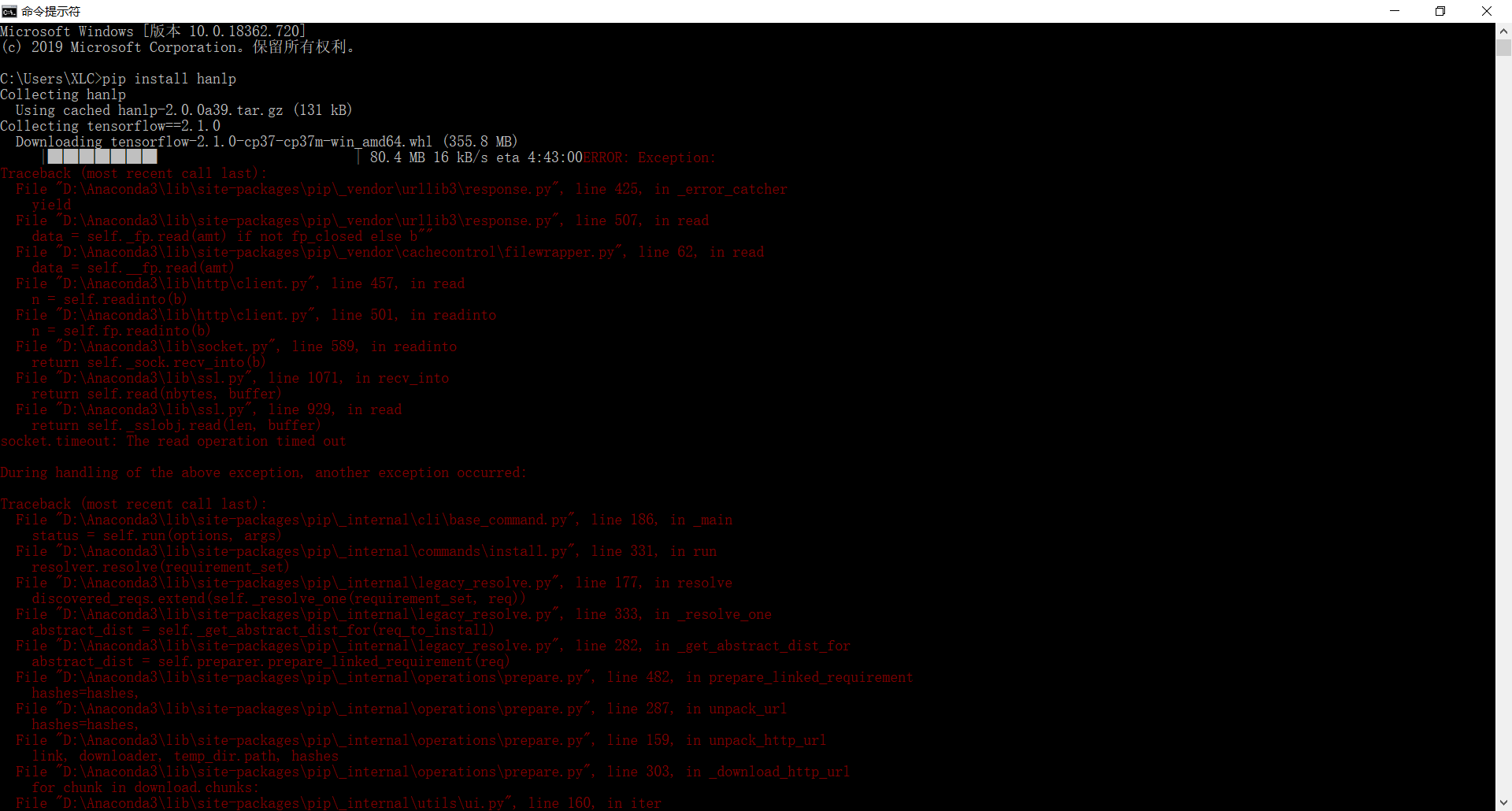

~/.hanlp。 - 不必下载全部子目录,注意看控制台输出,自己缺什么下什么。

- 有些目录是旧版本发布的模型,新版用不上。

- HanLP官方源大部分文件的下载速度很快,thirdparty里一些第三方的数据可能下载很慢,是你最需要的。

- 如果下载失败,等一个小时再试。

- 实在没办法的,还是老老实实翻墙吧。做科研的,不翻墙做不了。